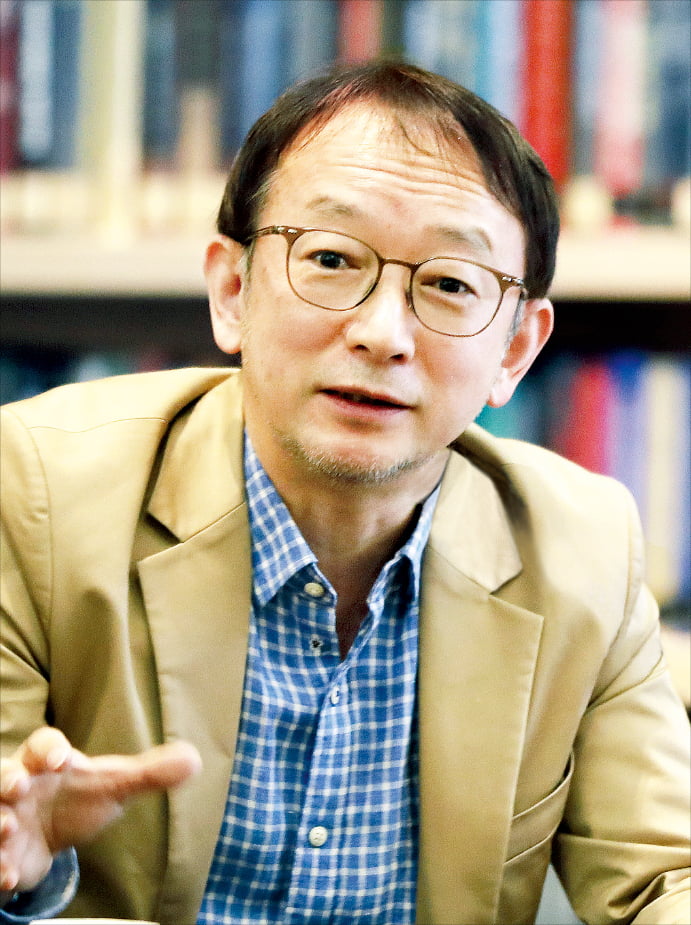

원라인에이아이 연구진 .

원라인에이아이 연구진 .금융 생성형 인공지능(AI) 솔루션 전문 기업 원라인에이아이(대표 정한얼)와 KAIST AI 연구진이 공동 연구해 발표한 논문 'Linguistic Generalizability of Test-Time Scaling in Mathematical Reasoning'이 세계적 권위의 자연어 처리 학회인 ACL(Association for Computational Linguistics) 2025 메인 콘퍼런스에 공식 채택됐다. 해당 논문은 AI 언어 모델의 테스트 타임 스케일링 추론 능력이 다양한 언어 환경에서도 유지되는지를 분석했다.

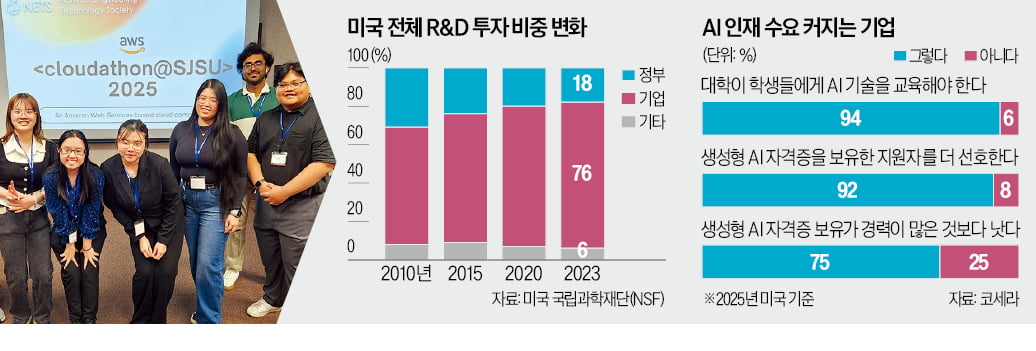

원라인에이아이는 올해 초에도 테스트 타임 스케일링을 이용한 모델을 발표한 바 있다. 테스트 타임 스케일링이란 모델이 실제 문제를 푸는 시점에서 계산 자원을 추가적으로 투입해 모델의 성능을 극대화하는 기법이다. 이번 연구에서는 이러한 테스트 타임 스케일링 기법들이 여러 언어 환경에서 균일하게 효과를 낼 수 있는지 검증했다. 원라인에이아이 연구팀은 이를 위해 다국어 수학 추론 평가를 위한 벤치마크 MCLM(Multilingual Competition Level Math)을 개발했다. 이 벤치마크는 총 55개 언어로 번역된 고난도 수학 문제들로 구성돼 있으며, 기존의 단순한 수학 문제보다 훨씬 복잡하고 경시대회 수준의 문제들로 구성돼 있다는 점이 특징이다.

연구팀은 이 데이터셋을 기반으로 Outcome Reward Modeling(ORM), Process Reward Modeling(PRM), Budget Forcing(BF) 등 세 가지 주요한 테스트 타임 스케일링 방식을 실험하고 비교 분석했다. 주목할 점은 논문에서 제안한 모델인 MR1-1.5B가 Budget Forcing 방식을 통해 우수한 성능을 발휘했다는 것이다. MR1-1.5B 모델은 상대적으로 적은 1.5B 파라미터를 가진 모델임에도, 벤치마크에서 동사이즈의 Qwen2.5-Math-1.5B-Instruct(23.98)와 DeepSeek-R1-1.5B(28.83) 보다 높은 30.93점을 기록해, 복잡한 수학적 추론에서 상당히 높은 성능을 나타냈다. 테스트 타임 스케일링 방식이 영어 환경 외 언어 환경에서도 효과적인지를 분석하기 위해 서로 다른 다양한 언어에서 성능을 분석했다.

원라인에이아이 관계자는 “이번 논문 발표와 함께 연구에 사용된 벤치마크 데이터셋인 MCLM을 오픈 소스 모델 및 데이터셋 공유 사이트인 HuggingFace에 공개하며, 향후 관련 연구에 널리 활용돼 글로벌 연구진들의 다양한 후속 연구에 도움이 되기를 기대한다”고 밝혔다.

원라인에이아이는 이번 ACL 2025 채택을 계기로 다국어 AI 기술 상용화에도 박차를 가하고 있다. 특히 이번 연구에서 축적된 다국어 수학 추론 및 테스트 타임 스케일링 기술은 자사에서 서비스 중인 글로벌 투자정보 플랫폼 Finola에 적용될 예정이다. Finola는 미국 주식시장 정보를 10개국 언어로 제공하며, 각국 투자자들이 언어의 장벽 없이 정교한 투자 인사이트를 얻을 수 있도록 돕는 생성형 AI 기반의 금융 비서 서비스다. 원라인에이아이는 Finola를 통해 AI 기술의 연구 성과를 실제 투자 현장에서 체감할 수 있는 서비스로 확장해 나갈 계획이다.

김현민 기자 minkim@etnews.com

1 month ago

8

1 month ago

8

English (US) ·

English (US) ·