이경준 아카마이코리아 대표

이경준 아카마이코리아 대표최근 한국에서는 인공지능(AI)을 더욱 빠른 속도로 도입하려는 움직임이 활발하게 일어나고 있다. 이는 향후 5년 이내에 한국을 세계 3대 AI 국가로 도약시킨다는 정부의 목표에 따른 것이다. 국내 기업이 '에이전틱 AI(Agentic AI)'라는 새로운 성장 동력을 활용하려면, AI 보안 리스크의 새로운 전선에 철저히 대비해야 한다.

에이전틱 AI는 자율적인 의사 결정 기능을 바탕으로 코드 생성부터 작업 실행까지 모든 작업을 수행할 수 있어 양날의 검이 될 수 있다. 사이버 공격자가 AI 취약성을 악용해 예측 불가능한 행동을 보이고 보안 허점을 파고들어 데이터 유출, 정교한 피싱 자동화, 멀웨어 생성, 적응형 대규모 공격으로 기존 보안 체계를 뚫을 수 있기 때문이다.

거대언어모델(LLM)은 에이전틱 AI의 핵심으로, 자연어(natural language)로 추론하고 계획하고 소통할 수 있는 기능을 제공한다. 그러나 LLM도 공격자가 보안 장치를 우회할 경우 민감한 데이터가 유출될 위기에 처할 수 있다. 예를 들어, 공격자는 프롬프트 인젝션(prompt injection) 기법을 통해 AI 응답을 탈취하고, LLM이 민감한 정보를 유출하거나 유해한 콘텐츠를 생성하도록 조작된 쿼리를 삽입할 수 있다. 또, 탈옥(jailbreaking) 기법을 통해 LLM 보안 장치를 우회하거나 허술하게 설계된 프롬프트와 같은 요인으로 인해 의도치 않게 데이터가 노출될 수 있다.

아울러 데이터 중독(data poisoning)을 통해 모델이 훼손될 수 있다. 아주 적은 양의 데이터를 대상으로 공격을 당할지라도 LLM의 의사결정 과정이 왜곡될 수 있다. 사기 탐지 모델을 예로 든다면, 공격자가 허위 데이터를 이용해 금융 범죄가 탐지되지 않도록 하는 것이 가능하다.

이에 따라 기업들은 모든 보안 취약점에 대한 경계를 늦추지 않는 것이 중요하다. 사내 AI 시스템을 철저하게 보호하는 것은 물론, 외부에서 들어오는 AI 기반 공격을 대비해야 한다. 공격자들은 이미 AI 기술을 악용해 공격기법을 정교화하고 있다. 예를 들어, AI 서비스용 응용애플리케이션인터페이스(API)가 노출된 경우 자동화된 프로빙(probing)과 악용 공격의 주요 타깃이 되고 있다. 실제로 아카마이의 인터넷현황보고서(SOTI)에 따르면 기업이 AI 도입에 있어 가장 크게 우려하는 부분은 AI 기반 애플리케이션과 API를 겨냥한 사이버 공격이 급증하고 있다는 점이다.

기업은 AI 생애주기 전반에 걸쳐 엄격한 데이터 거버넌스를 구현해 학습 데이터 세트 품질을 보장하는 것은 물론, LLM이 훼손되지 않도록 지속적으로 모니터링을 해야 한다. 여기엔 API와 데이터 파이프라인 전반에 걸쳐 제로 트러스트 원칙을 채택하는 것뿐만 아니라 AI 워크로드에 맞는 런타임 보안을 구현하는 것도 포함된다.

기업을 위한 대표적 솔루션으론 아카마이가 최근에 출시한 'AI 방화벽(Firewall for AI)' 보안솔루션이 있다. 솔루션은 무단 쿼리, 프롬프트 인젝션(prompt injection), 모델 탈취(model extraction)로부터 최신AI 스택을 보호하며 실시간 모니터링, 적응형 위협 탐지, 유해 데이터 및 컴플라이언스 위반에 대한 응답 필터링 기능을 제공한다.

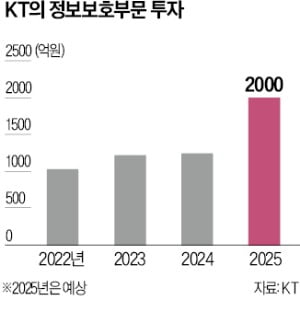

글로벌 차원에서도 AI 보안에 대한 관심이 고조되고 있다. 영국 시장조사 기관인 옴디아(Omdia)의 조사에 따르면, 2024년 세계 기업의 43%가 AI 도입에 따른 가장 큰 우려 사항으로 보안 및 데이터 프라이버시 문제를 꼽았다. 국내에서도 AI 전담 임원을 새로 임명하는 등 AI에 투자하는 기업이 늘고 있다. 그러나 기업이 AI 시스템 도입 초기 단계에 있든, 본격적으로 도입 절차를 밟고 있든, AI의 힘은 '보안'을 통해서만 발휘될 수 있다.

이경준 아카마이코리아 대표 kylee@akamai.com

조재학 기자 2jh@etnews.com

5 hours ago

1

5 hours ago

1

English (US) ·

English (US) ·