![빈센트 칼데이라 레드햇 아시아태평양(APAC) 최고기술책임자(CTO)가 28일 서울 강남구 웨스틴 서울 파르나스에서 열린 '레드햇 서밋 커넥트 서울 2025' 기자간담회에서 발언하고 있다. [사진=현대인 기자]](https://img.etnews.com/news/article/2025/10/28/news-p.v1.20251028.4252a1c803984760a21c46b841678842_P1.png) 빈센트 칼데이라 레드햇 아시아태평양(APAC) 최고기술책임자(CTO)가 28일 서울 강남구 웨스틴 서울 파르나스에서 열린 '레드햇 서밋 커넥트 서울 2025' 기자간담회에서 발언하고 있다. [사진=현대인 기자]

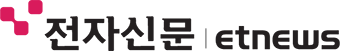

빈센트 칼데이라 레드햇 아시아태평양(APAC) 최고기술책임자(CTO)가 28일 서울 강남구 웨스틴 서울 파르나스에서 열린 '레드햇 서밋 커넥트 서울 2025' 기자간담회에서 발언하고 있다. [사진=현대인 기자]“인공지능(AI) 제품 출시 단계에 있는 기업들이 직면한 신뢰성·운영 효율성 확보 문제는 오픈소스로 해결할 수 있습니다.”

빈센트 칼데이라 레드햇 아시아태평양(APAC) 최고기술책임자(CTO)는 28일 서울 강남구 웨스틴 서울 파르나스에서 열린 '레드햇 서밋 커넥트 서울 2025' 기자간담회에서 AI 시대 오픈소스 전략을 제시하며 이같이 말했다.

칼데이라 CTO는 현재 세계 AI 도입 흐름이 변곡점에 있다고 짚었다. 기업 대부분이 AI 제품에 대한 개념검증(PoC)을 넘어 제품화 단계로 넘어가면서 새로운 문제에 직면했다는 것이다.

칼데이라 CTO는 “AI 제품에 대한 PoC는 제한된 데이터와 유저를 기반으로 진행된 것이지만, 수십만명이 이용하는 실제 제품의 운영 비용은 폭발적으로 증가한다”며 “AI 모델의 학습 데이터, 잘못된 정보를 생성할 가능성 등 AI 제품에 대한 낮은 신뢰성도 제품화를 어렵게 하는 문제”라고 설명했다.

그는 이어 “레드햇은 투명성과 감사 가능성을 확보하는 오픈소스 접근법으로 이러한 문제를 해결한다”고 부연했다.

구체적으로 △투명성 확보를 위해 리눅스 재단과 함께 개발한 모델 개방성 프레임워크 채택 △책임 있는 AI 개발·배포를 위한 오픈소스 커뮤니티를 통한 지속적인 모니터링과 편향 감지, 런타임 가드레일 구현 등을 예시로 들었다

AI 서비스 운영 효율화를 위한 오픈소스 기반 기술도 제공한다.

칼데이라 CTO는 “vLLM, llm-d, 쿠버네티스를 통해 AI 추론 효율화를 지원하고 있다”고 말했다.

AI 추론 최적화 오픈소스 커뮤니티인 vLLM은 페이지드어텐션과 연속 배칭을 통해 그래픽처리장치(GPU) 메모리 사용을 최적화하고 처리량을 최대 24배 향상시킨다.

구글, 엔비디아 등 글로벌 기업이 참여하는 분산 추론 오픈소스 프로젝트 llm-d은 AI 인식 라우팅과 동적 오토스케일링을 구현해 GPU 활용도를 극대화한다.

칼데이라 CTO는 이어 “이러한 모든 요소는 이달 출시한 레드햇 AI 3 플랫폼에 통합돼 있다”며 “레드햇 AI 3는 오픈시프트 위에서 구동돼 기업들이 새로운 플랫폼을 채택하지 않고 AI 제품화 단계를 가속화할 수 있도록 지원한다”고 강조했다.

![김경상 한국레드햇 사장이 28일 서울 강남구 웨스틴 서울 파르나스에서 열린 '레드햇 서밋 커넥트 서울 2025' 기자간담회에서 발언하고 있다. [사진=현대인 기자]](https://img.etnews.com/news/article/2025/10/28/news-p.v1.20251028.725d4d8e1bd7435986384356f318df33_P2.png) 김경상 한국레드햇 사장이 28일 서울 강남구 웨스틴 서울 파르나스에서 열린 '레드햇 서밋 커넥트 서울 2025' 기자간담회에서 발언하고 있다. [사진=현대인 기자]

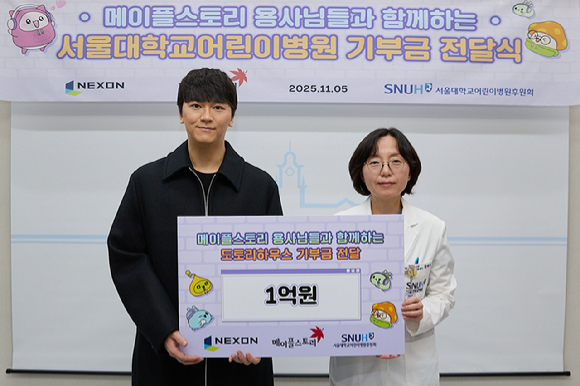

김경상 한국레드햇 사장이 28일 서울 강남구 웨스틴 서울 파르나스에서 열린 '레드햇 서밋 커넥트 서울 2025' 기자간담회에서 발언하고 있다. [사진=현대인 기자]이어진 발표에서 김경상 한국레드햇 사장은 내년 사업 목표를 제시했다.

김 사장은 “내년 주요 사업 목표는 '국내 고객의 AI 확산에 지속 기여'와 '효율 향상 및 현대화를 통한 클라우드 최적화 지원'”이라고 설명했다.

AI 확산을 위해선 레드햇 AI 3 플랫폼을 통한 AI 서비스 추론 효율화를 지원한다. 또한 기업 내부 데이터를 학습시킨 자체 AI 모델을 온프레미스, 프라이빗 클라우드에서 구현할 수 있도록 하는 개방형 아키텍처 툴도 제공한다.

효율 향상 및 현대화를 위해선 △운용체계(OS) 'RHEL 10', 자동화 플랫폼 '앤서블' 등을 활용한 정보기술(IT) 자원 효율화 △'데이 2'에 초점을 맞춘 IT 운영 현대화 등에 초점을 맞춘다.

김 사장은 “한국 기업들의 디지털 전환(DX)과 AI 혁신을 통해 경쟁력 강화에 기여하고, 국내 IT 전문가들이 레드햇 오픈소스 기술을 최대한 경험할 수 있는 기회를 확대할 것”이라고 말했다.

현대인 기자 modernman@etnews.com

1 week ago

8

1 week ago

8

![[종합] 게임·결제 등 고른 성장…NHN 3분기 흑자 전환](https://image.inews24.com/v1/e334a900b39169.jpg)

![[컨콜] NHN "'디시디아 듀엘럼 파이널 판타지', 라인업중 가장 높은 매출 기대"](https://image.inews24.com/v1/f9ab67a2b86f37.jpg)

![닷컴 버블의 교훈[김학균의 투자레슨]](https://www.edaily.co.kr/profile_edaily_512.png)

English (US) ·

English (US) ·