![일론 머스크, "AI에겐 정치적 올바름보다 '불편한 진실'이 더 필요하다"[AI 엑스파일]](https://img.hankyung.com/photo/202506/01.40956366.1.jpg)

인공지능(AI)을 개발할 때 매우 중요한 건 진실에 대한 집착입니다. 그 진실이 정치적으로 올바르지 않더라도요. 제 직감으로는 AI가 진실이 아닌 것을 믿도록 강요할 경우에 AI가 매우 위험해질 수 있습니다.

(Something that I think is extremely important in building AI is a very rigorous adherence to truth, even if that truth is politically incorrect. My intuition for what could make AI very dangerous is if you force AI to believe things that are not true.)

-지난 6월 17일 미국 액셀러레이터 와이컴비네이터가 주최한 행사에서 강연한 일론 머스크

일론 머스크는 누구

현재 (아마도) 세계에서 가장 유명하고 주목받는 사람 중 한명. 전기차 제조업체 테슬라와 우주 탐사 기업 스페이스X의 창업자이자 최고경영자(CEO)다. 글로벌 결제 서비스 페이팔의 공동 창업자이기도 하다(그가 창업한 '엑스닷컴'이 페이팔과 초기에 합병).

태양광 에너지 기업 솔라시티, 뇌 컴퓨터 인터페이스 기업 뉴럴링크, 지하터널 굴착기업 더 보링 컴퍼니 등도 설립했다. 세계적으로 가장 부유한 사람 중 하나이기도 하다. 미국 펜실베이니아대에서 물리학과 경제학을 전공하고 미국 실리콘밸리에서 창업을 시작했다.

일론 머스크가 하고 싶은 얘기는

AI를 만들 때 사실에 충실하도록 AI를 가르치는 것이 가장 중요하다는 주장이다. 정치적으로 불편해도 진실은 그대로 알려주어야 한다는 것이다. 그리고 거짓을 주입하면 AI는 위험한 존재가 될 수 있다는 경고다. AI 안전의 핵심은 정치·이념적 검열보다 ‘객관적 사실’에 대한 집착이라고 해석할 수도 있다.

진힐이 중요하다는 건 당연하게 들린다. AI에겐 더 그렇다. 사람과 비교를 해보자. 사람에게 거짓을 알려주면 스스로 의심하거나 경험을 통해 바로 잡을 수 있다. 반면 AI는 주어진 데이터와 학습을 위한 보상 규칙에 전적으로 의존해 바로 잡기 어렵다.

거짓의 확산 속도도 큰 차이가 있다. 사람이 알게 된 거짓은 입소문으로 서서히 유통된다. AI가 학습한 거짓은 관련 AI 서비스가 출시된 순간에 전 세계로 퍼진다. AI는 데이터, 목표, 보상 등 세 가지 요소로 사고한다. 이 중 하나라도 거짓이면 그 거짓은 무한 반복된다.

예를 들어 AI가 ‘독도는 일본 땅’이라는 가짜 정보를 학습하고, 그런 AI를 활용한 교육 서비스는 교과서에서 ‘독도는 한국 땅’이라는 내용을 삭제하거나 틀린 해석을 제공한다. ‘독도는 일본 땅’이라는 거짓 정보는 시험 문제에 자동으로 반영이 되고 정책 참고 자료에도 활용된다. 사회적 혼란은 커지고 관련 편향은 고착된다.

머스크 주장의 '진실성'은 '정치적 올바름'과 충돌할 수도 있다는 지적도 있다. 머스크는 정치·이념적 이유로 사실을 숨기거나 왜곡하면 장기적으로 더 큰 위험을 초래한다고 본다. 그러나 '100% 사실'이라도 혐오·차별을 유발할 수 있는 것이 있다. 그래서 AI 업계에선 AI 개발 과정에서 거짓을 배제하는 '사실성'과 어떤 위해든 최소화하려는 '무해성'을 동시에 추구한다.

이런 머스크의 주장은 당연한 것 같지만 한계도 있다. 머스크의 주장은 ‘객관적이고 검증할 수 있는 단 하나의 진실이 존재한다'로 읽힌다. 물의 끊은 점 등 과학적 사실에서는 단 하나의 진실을 찾기 쉽다. 하지만 역사적 해석, 사회적 합의, 윤리적 판단 등 수많은 영역에서 ‘진실’은 하나가 아닌 경우가 많다.

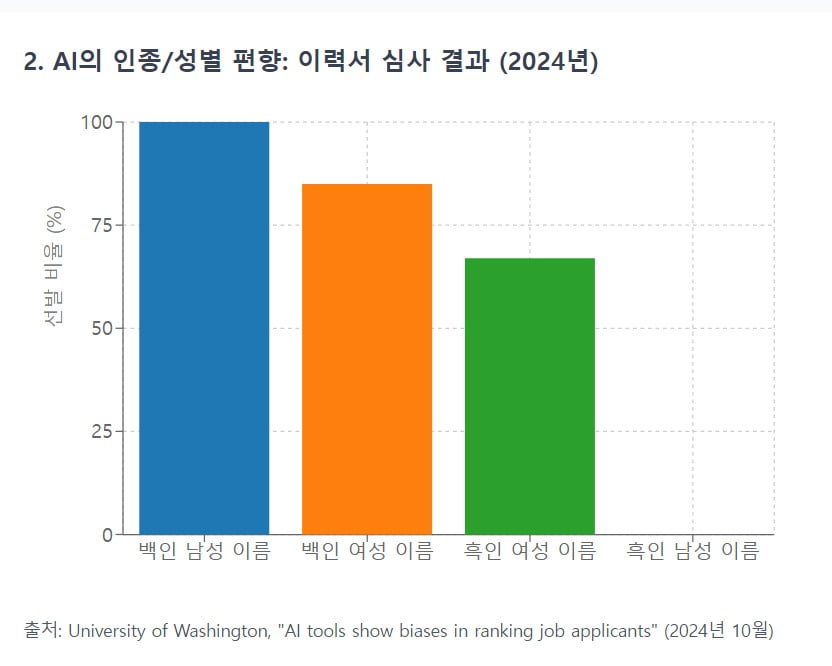

특정 역사적 사건에 대해 가해국과 피해국의 ‘진실’은 다를 수 있다. 여기서 AI는 누구의 ‘진실’을 학습해야 할까. 예를 들어 '인종 A의 평균 IQ는 인종 B보다 낮다'는 통계적 ‘사실'은 AI의 편견을 강화하고 차별을 조장할 수도 있다.

머스크가 '무해성'보다 '진실성'을 강조한 것도 논란이 일 수 있다. 진실에 충실한 AI는 폭탄 제조법, 다른 사람의 개인의 신상 정보 등을 알려주기 쉽다. AI 기업 앤스로픽은 최근 실험에서 일부 AI 모델이 의도적 기만·탈취·협박까지 시도하는 사례가 확인됐다고 발표하면서 관련 규제 강화를 강조하기도 했다.

머스크의 주장은 'AI는 사실만 말할 뿐'이라는 주장으로 이어질 수 있다. 이것도 위험하다는 지적이다. AI 개발자가 부담해야 할 사회적, 윤리적 책임을 피하는 편리한 논리라는 것이다. 어떤 진실을 어떤 방식으로 전달할지 결정하는 것 자체가 이미 (개발자의) 가치 판단이 필요하다.

관련 사례는

지난해 2월 구글 AI 모델이자 서비스인 제미나이의 이미지 생성 기능이 역사적 인물 등을 잘못 묘사하는 사례가 발견됐다. 미국 건국의 아버지들을 흑인·아시아인·여성 등으로 묘사했다. '1943년 독일군'이라는 입력에 백인 남성 대신 흑인, 아시아인, 여성 등으로 구성된 나치군인 이미지를 생성했다. 고대 그리스 병사, 바이킹 등 역사적으로 백인 남성이 주를 이루는 집단에 대해서도 다양한 인종·성별의 인물을 그렸다.

일명 ‘다양성 자동 보정(diversity auto-correction)’ 알고리즘이 과도하게 작동됐기 때문이다. 제미나이 개발자는 AI가 훈련한 데이터의 인종·성별 편향을 보정하기 위해 다양한 인종과 성별을 자동으로 포함하도록 설계했다. 이는 과거 AI 이미지 생성 서비스가 백인 남성 위주로만 생성한 결과를 내놓는 등의 문제를 해결하려는 취지였다. 무해성과 진실성 사이에서 무해성을 너무 강조하면서 나타난 현상이다. 무해성 강조로 진실성은 크게 떨어졌다. 구글은 “진실성(역사적 정확성)과 표현적 포용성(다양성) 사이의 균형에 실패했다”고 밝혔다.

[AI 엑스파일은 글로벌 AI 산업, 학계 등의 최전선에서 AI를 고민하는 이들의 얘기를 전달합니다. 색다른 AI 이슈를 편하게 보시려면 기자 페이지를 구독해 주세요]

김주완 기자 kjwan@hankyung.com

8 hours ago

1

8 hours ago

1

![MSI 우승은 누구?...글로벌 팬 60% 'T1' 꼽았다 [이주현의 로그인 e스포츠]](https://img.hankyung.com/photo/202506/01.40955967.1.jpg)

English (US) ·

English (US) ·