[IT동아 남시현 기자] 지난 10월 21일, Arm이 글로벌 AI 반도체 파트너사와 산업 생태계 협력을 위한 ‘Arm 언락드 코리아 2025(Arm Unlocked Korea 2025)’를 개최했다. Arm 언락드 코리아는 Arm 테크 심포지아를 계승하는 행사다. 지난 행사까지는 반도체 자산 관련 기술에 주력했으나 앞으로는 AI 리더십과 AI 컴퓨팅 전환이라는 포괄적인 주제를 다룬다. 이는 Arm이 설계 라이선스 제공에만 집중했던 과거의 전략에서 벗어나 데이터센터 및 AI 인프라로 영향력을 확대하고, 직접 칩을 설계하며 시장과 경쟁하고 나서는 전략과 관련있다.

차량·인프라·일반 사용자 분야서 국내외 Arm 파트너사 총출동

지난 10월 21일 열린 Arm 언락드 코리아 2025에서 Arm 기반 장치에 대한 AI 모델 양자화 관련 세션이 진행됐다 / 출처=IT동아

지난 10월 21일 열린 Arm 언락드 코리아 2025에서 Arm 기반 장치에 대한 AI 모델 양자화 관련 세션이 진행됐다 / 출처=IT동아

앞서 4월, Arm은 반도체 시장에 다각적으로 접근하기 위해 서버용 ‘네오버스’만 있던 컴퓨팅 서브 시스템(CSS) 브랜드를 ▲서버용 네오버스 ▲PC용 니바(Niva) ▲자동차용 제나(Zena) ▲사물인터넷용 오르비스(Orbis) ▲모바일용 루멕스(Lumex)로 각각 세분화했다.

이에 따라 Arm 언락드 코리아 역시 ▲ Arm 제나 및 칩렛 아키텍처, 가상 플랫폼 등이 포함된 오토모티브(차량) ▲Arm CSS, 네오버스 CSS, 모듈식 펌웨어, 칩렛 통합 등을 다루는 인프라스트럭처 ▲ Armv9 CPU 및 GPU, SME2, 시스템 등을 다루는 컨슈머 디바이스(일반 사용자용 제품군) 세 개 분야로 나뉘어 진행됐다.

세션은 크게 오토모티브, 인프라스트럭처, 컨슈머 디바이스로 나뉘었고 일반 사용자 장치에 대응하는 컨슈머 디바이스의 참여 비중이 가장 높았다 / 출처=IT동아

세션은 크게 오토모티브, 인프라스트럭처, 컨슈머 디바이스로 나뉘었고 일반 사용자 장치에 대응하는 컨슈머 디바이스의 참여 비중이 가장 높았다 / 출처=IT동아

세션에는 한국지멘스, 케이던스 디자인 시스템즈, LG전자, 시높시스, 삼성전자, KT클라우드 등 대기업은 물론 에이직랜드, 텔레칩스, 스트라드비젼, 코아시아, 가온칩스, 하일로 등의 국내외 Arm 반도체 관련 기업들도 대거 참여했다. 굵직한 반도체 기업들이 참여하는 가운데 스타트업으로는 유일하게 에너자이가 연단에 섰다. 특히 하드웨어 및 반도체 기업이 아닌 소프트웨어 기업이라는 점에서 Arm의 생태계 확대 의지를 엿볼 수 있다.

에너자이는 지난 2022년 ‘Arm AI 파트너 프로그램’에 선정된 AI 모델 양자화 기술 기업이다 / 출처=에너자이

에너자이는 지난 2022년 ‘Arm AI 파트너 프로그램’에 선정된 AI 모델 양자화 기술 기업이다 / 출처=에너자이

에너자이는 말단 통신 장치인 엣지 디바이스나 스마트폰 등에서 자체적으로 AI를 처리할 수 있을 정도로 AI 모델을 압축하는 모델 양자화 기술, AI 추론 최적화 엔진인 옵티미움(Optimium)을 개발 중이다. 대형언어모델(LLM)이나 음성 모델, 번역 모델 등의 활용도가 높아지면서 스마트폰, 노트북 혹은 더 작은 장치에서도 AI를 도입하려는 상황이지만 기기의 성능 제약이 발목을 잡는 상황이다. 대형언어모델로는 작은 편인 메타 Llama 3.1-8B를 구동해도 최신 노트북 수준인 16GB의 시스템 메모리와 12GB 내외의 비디오 메모리가 필요하다.

일반적인 AI 모델은 32비트 규격인데, 소형 장치의 성능 한계에서 원활하게 모델을 구동하려면 용량과 사양을 줄이는 양자화 작업이 필요하다 / 출처=Advances in the Neural Network Quantization: A Comprehensive Review 논문

일반적인 AI 모델은 32비트 규격인데, 소형 장치의 성능 한계에서 원활하게 모델을 구동하려면 용량과 사양을 줄이는 양자화 작업이 필요하다 / 출처=Advances in the Neural Network Quantization: A Comprehensive Review 논문

업계에서는 AI 모델 연산을 처리할 때 정밀한 실수 대신 더 짧은 정수로 변환해 연산량과 용량은 줄이고, 성능은 최대한 유지하는 기술을 개발 중이다. 쉽게 말해 압축 기술이라 할 수 있으며 업계 용어로 ‘모델 양자화’라 부른다. 일반적인 AI 모델은 32비트 부동소수점(float32)으로 제작되며 이를 8비트로 줄이면 메모리 사용량은 약 4배 감소하고, 처리 속도도 2배에서 4배까지 빨라진다.

여기서 더 나아가 2비트 수준으로 양자화하면 28GB인 Llama 3.1 8B AI 모델의 용량은 약 2GB에 메모리는 5~8GB까지 줄어 스마트폰에서도 구동할 수 있다. 모델 성능이 일부 손실되지만 요구 사양과 용량이 대단히 감소한다는 이점이 있다. 4비트 이하부터는 극단적 양자화라 하며, 에너자이는 1.58비트 양자화 알고리즘으로 저출력, 초소형 기기에서도 온전하게 AI 모델이 구동되도록 하는 기술을 개발 중이다.

AI 최적화가 필요한 LG전자, 이를 다루는 에너자이

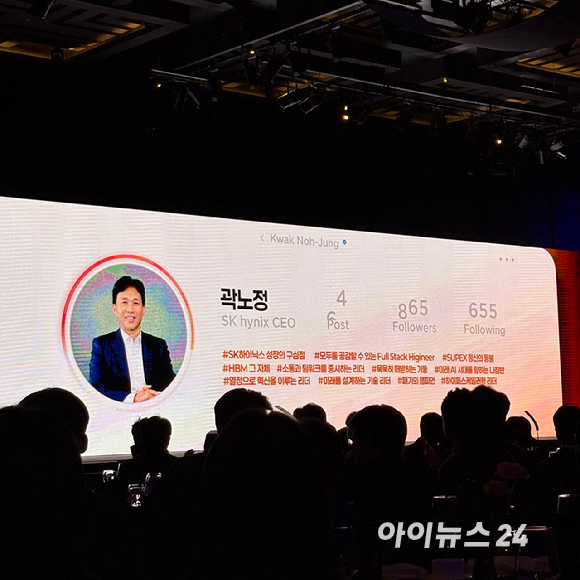

에너자이는 컨슈머 디바이스 분야 중 ‘다양한 Arm 에코시스템 전반에서 온디바이스 AI의 확장’ 세션에 참여했다. 발표는 LG전자 텔레비전의 운영 체제인 웹OS(webOS)의 AI 시스템 소프트웨어 팀의 우성호 LG전자 연구위원과 이인철 LG전자 팀장, 그리고 장한힘 에너자이 대표가 Arm 시스템온칩(SoC) 기반 LG 스마트 TV에서의 AI 개발 및 배포 과정, 그리고 모델 양자화로 이를 극복할 수 있는 이유 등에 대한 대담을 나눴다.

좌측부터 황지희 Arm 이사, 우성호 LG전자 연구위원, 이인철 LG전자 팀장, 장한힘 에너자이 대표 / 출처=IT동아

좌측부터 황지희 Arm 이사, 우성호 LG전자 연구위원, 이인철 LG전자 팀장, 장한힘 에너자이 대표 / 출처=IT동아

이인철 팀장은 “오늘날 많은 LG 가전에 AI가 통합되고 있다. 소비자들이 필요로 하는 것을 가전이 알아서 구성하고, 더 나아가 선제적으로 제공하는 것을 목표로 한다. 다만 보급형부터 프리미엄까지 기기 성능이 다 다르고, 제한된 사양으로 이를 실현해야 하는 어려움이 있다. 양자화를 통해 AI 모델을 경량화하고 다양한 기기에 공통적으로 적용할 수 있게 최적화할 수 있다”라면서, “웹OS TV만 해도 약 2억 대 이상에 5년 간 업그레이드를 한다. Arm SoC가 장착된 제품은 클라이디AI(KleidiAI)를 활용해 이를 통합적으로 관리할 수 있어 사업상 최적의 효율을 발휘한다”라고 말했다. 클라이디AI는 Arm 기반 장치에서 AI를 구동하고 최적화를 돕는 도구다.

우성호 연구위원도 “고객들이 경험하는 AI는 발전하고, 눈높이는 갈수록 높아진다. 이제 가전에도 2.4B(24억 개 매개변수) 대형언어모델이 구현되고, 품질 손실이 조금 있더라도 더 많은 기능을 제공하는 것이 중요해진다”라고 말했다. 이어서 “어떤 모델은 32비트를 8비트로 바꾸는 것만으로도 성능이 크게 떨어진다. 딱 하나의 기법이나 특정 모델만으로 해결할 수 있는 문제는 아니다. 많은 실험과 시도, 노하우가 중요하다. LG전자 제품의 파이프라인과 에너자이의 경량화 노하우를 결합한다면 상당한 시너지를 낼 것”이라고 진단했다.

장한힘 대표가 에너자이가 양자화를 진행하는 방식, 그리고 옵티미엄 엔진을 활용하는 방안 등을 설명 중이다 / 출처=IT동아

장한힘 대표가 에너자이가 양자화를 진행하는 방식, 그리고 옵티미엄 엔진을 활용하는 방안 등을 설명 중이다 / 출처=IT동아

에너자이는 기기마다 다른 하드웨어 스펙, 그리고 AI 양자화 과정에서 정확도가 손실되는 것을 감안해도 최대한 성능을 보전할 수 있는 접점을 찾는다. 모델 구축 후에 양자화를 진행하는 사후 양자화(PTQ)와 추가적인 학습을 더해 성능을 보전하며 양자화하는 양자화 인지 학습(QAT)을 복합적으로 적용해 최적의 값을 찾는다.

장한힘 대표는 “프로젝트 수행 전 고객의 목표와 요구사항을 설정하고, 무수한 실험을 통해 정확도와 효율성을 도식화한다. PTQ는 개발 비용이나 속도 면에서 좋지만 4비트 정도가 한계다. 그 이하는 QAT로 성능을 확보하며 양자화한다. 에너자이는 QAT 기반으로 1.58비트까지 양자화한다. 비용이나 속도 등을 고려해 향후에는 PTQ 기반 초미세 양자화도 구현하려 한다. 다각적으로 양자화한 결과를 조합하면 성능과 효율의 균형 곡선이 산출돼 이를 기반으로 최적화한다”라고 말했다.

LSTM(긴 단기 기억, Long Short-Term Memory) 기반 딥러닝 모델을 양자화하는 과정을 시연 중인 화면 / 출처=Arm

LSTM(긴 단기 기억, Long Short-Term Memory) 기반 딥러닝 모델을 양자화하는 과정을 시연 중인 화면 / 출처=Arm

에너자이는 고객사 요구에 맞춰 100MB 이내로 동작하는 최적화된 경량 언어 모델을 수백만 대 이상의 디바이스에 상용 배포한 경험도 있고, 옵티미엄을 활용해 특정 SoC에서 AI가 동작할 때 신경망처리장치(NPU) 대신 CPU로 배정해 실시간 성능을 확보하는 작업도 수행했다. 또한 Arm 기반 장치로 구동되는 의료 기기들에서 데이터를 수집해 진단 과정에 참여하는 상용 서비스나 오토모티브용 Arm SoC를 활용한 AI 모델 구현 사례도 확보 중이다.

CPU·GPU·NPU가 AI 분산 작업하는 방안도 소개

우성호 LG전자 연구위원이 NPU, GPU, CPU 관련 자원 배분에 대한 생각을 말하고 있다 / 출처=IT동아

우성호 LG전자 연구위원이 NPU, GPU, CPU 관련 자원 배분에 대한 생각을 말하고 있다 / 출처=IT동아

장한힘 대표는 “하나의 모델을 통째로 배정하는 게 아니라 SoC에 탑재되는 구성 요소에 각각 맞는 작업을 입체적으로 할당하는 식의 접근법도 필요하다. 예를 들어 초소형 SoC로 유튜브를 라이브스트리밍 한다고 할 때, 영상은 CPU로 처리하고 오디오를 텍스트로 전환한 뒤 자막으로 변한하는 과정은 NPU에 할당하는 식으로 할당한다. 이를 통해 최적의 작업을 배정하고 모델 성능과 메모리 효율 간의 최적의 균형을 찾아낼 수 있다”라고 말했다.

우성호 연구위원 역시 “GPU의 AI 처리 성능이 가장 높지만 전력 효율과 단가가 비싸다. 저전력 환경에서는 AI 모델 자체를 효율적으로 구성하거나 NPU 등을 잘 활용하는 게 중요해질 것이다. 현재는 CPU, NPU, GPU의 자원 할당이 정적인 방식으로 진행되지만 추후에는 세 요소가 안정성과 효율성, 가속 등을 복합적으로 운용하도록 발전할 것 같다”라는 의견을 더했다.

극단적 최적화에 비용과 효율 모두 잡는 ‘해답’이 있다

1.58비트 양자화 같은 극단적인 최적화 방안은 엣지 컴퓨터 등 초소형 컴퓨팅 시스템에서 AI를 구현하기 위한 해결책이다. 다르게 말하자면 저성능 컴퓨터에서도 AI를 효율적으로 구동하고, 동일한 시스템 자원에서 더 높은 연산 효율로 AI 성능을 극대화하는 기술이다. 단순히 모델을 압축하는 것 뿐만 아니라 CPU와 NPU, GPU의 처리 효율에 맞게 입체적으로 명령을 할당하고 각기 다른 칩을 모두 충족하는 최적값을 찾아가며 극단적 최적화 기술이 발전하고 있다.

극단적 최적화가 필요한 이유는 AI에 익숙한 사용자들이 모델 성능의 저하를 확실히 체감하기 때문이다. 당장 많은 사용자가 GPT-4와 GPT-5의 격차가 분명하다고 말한다. 과거에는 5년 지난 TV는 그냥 옛날 제품이었지만 AI를 탑재하는 TV라면 시간 흐름에 맞춰 계속 성능이 진화해야만 소비자가 외면하지 않는다.

이번 발표는 Arm 기반 장치에서 AI를 양자화하고, 이를 다양한 조건에 배포하는 작업을 수행중인 기술자, 개발자들에게 좋은 참고 사례가 되었다 / 출처=IT동아

이번 발표는 Arm 기반 장치에서 AI를 양자화하고, 이를 다양한 조건에 배포하는 작업을 수행중인 기술자, 개발자들에게 좋은 참고 사례가 되었다 / 출처=IT동아

이번 발표의 사례로 등장한 LG전자 텔레비전만 해도 수억 대며 제각기 성능이 다른 수백 개 이상의 모델로 파편화돼 있다. 모든 제품이 최적의 성능을 낼 수 있도록 업데이트하고 장기적으로 AI 모델이 흐름에 맞춰 진화해야 살아남는 시대다. 하지만 몇 년 지난 텔레비전의 CPU와 메모리 성능이 바뀔리 없으니 모델 양자화를 통해 AI 효율을 개선하는 것이 최적의 해결 방안이다. 그런 점에서 에너자이의 기술력과 노하우는 LG전자는 물론 모든 IT 업계에서 주목하는 기술이며, Arm이 협력하는 것도 이 이유 때문이다.

IT동아 남시현 기자 (sh@itdonga.com)

3 hours ago

1

3 hours ago

1

![화장품 소재 발굴부터 생산까지 과학자가 직접 책임진다…’위튼컴퍼니’ [혁신스타트업 in 홍릉]](https://it.donga.com/media/__sized__/images/2025/10/22/ea54ec91c13a4986-thumbnail-960x540-70.jpg)

![[뉴스줌인] 삼성 갤럭시 XR 출시, 애플 비전 프로 넘을까?](https://it.donga.com/media/__sized__/images/2025/10/22/f058c9cc5c174d9e-thumbnail-960x540-70.jpg)

![해킹 사고 반복 시 징벌적 가중 처벌...신고 안 해도 직권 조사 [일문일답]](https://image.inews24.com/v1/80c7ccc1af216f.jpg)

English (US) ·

English (US) ·