![[AX 혁신의 주역]래블업, GPU 분할 가상화로 AI 워크로드 효율 극대화](https://img.etnews.com/news/article/2025/04/22/news-p.v1.20250422.4062c0110b344300ab73000739a25795_P1.png)

래블업이 그래픽처리장치(GPU) 분할 가상화로 인공지능(AI) 워크로드 효율성을 극대화한다. AI 인프라 운영 플랫폼 '백엔드닷에이아이(Backend.AI)'를 개발, 서비스하고 있다.

2015년 신정규 대표, 김준기 최고기술책임자(CTO), 박종현 연구소장이 계산과학 분야 연구 자동화 플랫폼을 만들자는 목표로 모인 회사다. 신 대표는 포스텍 물리학부에 재학하던 시절 대규모 연구 클러스터를 관리하며 매일 고장나는 장비와 시스템 오류를 수정하는 데 상당한 시간과 비용 손실을 경험하며 머신러닝 기술 발전에 맞춰 표준화된 컴퓨팅 플랫폼의 필요성을 예측했다.

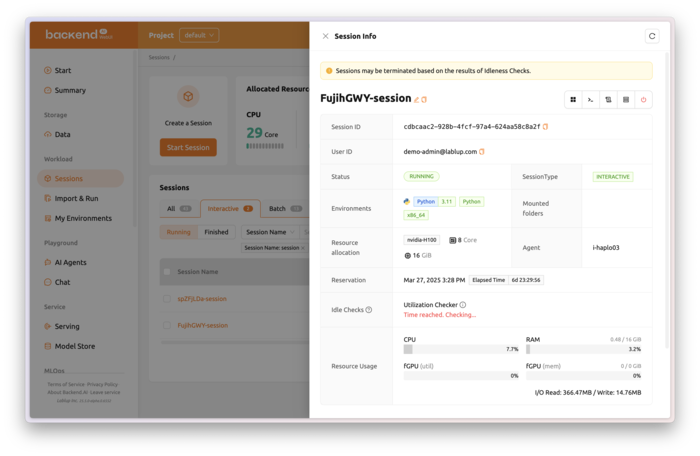

래블업 백엔드닷에이아이는 AI 개발·서비스, 고성능 컴퓨팅(HPC)을 위한 엔터프라이즈 클러스터·클라우드 운영 플랫폼이다. 대규모 AI 프로젝트에서 어떤 팀이 어떤 GPU를 얼마나 사용하고 있는지 추적이 어려워 GPU 실제 성능을 전부 활용하지 못하는 경우가 빈번하다.

백엔드닷에이아이는 래블업이 특허를 가진 'GPU 분할 가상화' 기술로 하나의 GPU를 가상화, 여러 개의 작은 GPU로 나눠 유휴 자원을 최대한 활용하도록 지원한다. 독자 개발한 '소코반' AI 오케스트레이터는 시스템 상태와 워크로드 종류에 따라 AI 워크로드를 분배·실행해 효율을 극대화한다. AI·HPC 워크로드 가속을 위해 필수적인 데이터 플레인 가속과 GPU·GPU 네트워크 최적화도 지원한다.

래블업 '백엔드닷에이아이(Backend.AI)' 플랫폼 예시. 회사 제공

래블업 '백엔드닷에이아이(Backend.AI)' 플랫폼 예시. 회사 제공래블업은 고객이 목적에 맞는 AI 가속기를 사용할 수 있도록 다양한 종류의 AI 가속기에도 대응했다. 백엔드닷에이아이는 엔비디아, 인텔, 그래프코어, AMD 등 현존하는 대부분의 AI 가속기와 다양한 아키텍처를 지원한다.

기술 우위에 힘입어 한국은행, 삼성전자, 현대모비스, 포티투닷을 비롯해 국내외 100여곳 이상 백엔드닷에이아이 고객사를 확보했다. AI 인프라와 서비스 관리가 편리하고 비용이 절감됐다는 게 공통된 고객사 피드백이다.

래블업은 백엔드닷에이아이를 확장해 다양한 응용 제품군을 선보이고 있다. 오픈소스 모델을 쉽고 효율적으로 사용할 수 있도록 하는 '빨리(PALI)', 전용 하드웨어 어플라이언스 '빨리 빨리(PALI PALI)'를 국내외에 판매하고 있다.

거대언어모델(LLM)을 사용해 사용자 모델을 미세조정할 수 있는 '파인튠.잉(Finetun.ing)'의 베타 테스트도 진행 중이다. 최근 AI 에이전트를 연동하는 규격인 모델 콘텍스트 프로토콜(MCP)과 구글 A2A를 래블업이 2019년부터 오픈소스로 공개한 보안연결 터널링 소프트웨어 캘로섬(Callosum)으로 안전하게 사용할 수 있게 통합하고 있다.

신정규 래블업 대표

신정규 래블업 대표래블업은 클라우드 내결함성 솔루션 '백엔드닷에이아이 컨티넘(Backend.AI Continnum)' 역시 곧 상용화할 예정이다.

신정규 대표는 “엄청난 속도로 다양해지는 AI 워크로드를 가장 효율적이고 쉽게 사용하도록 지원한다”며 “응용 AI 분야가 커질수록 중요해지고 있는 스케일과 보안·안정성은 서로 뗄 수 없는 문제”라고 말했다. 이어 “래블업은 이러한 문제의 실타래를 풀어내 모두가 효율적이면서 안전하게 AI를 만들고 사용하는 세상에 도달하는 과정을 가속화하고 있다”고 덧붙였다.

박종진 기자 truth@etnews.com

1 month ago

7

1 month ago

7

![[신차공개] 현대 '더 뉴 엑시언트'·'디 올 뉴 넥쏘' 판매 개시](https://it.donga.com/media/__sized__/images/2025/6/18/3efc333b0f1b4324-thumbnail-960x540-70.jpg)

![[포토] 트리플에스 설린, '눈 뗄 수 없는 예쁨'](https://img.hankyung.com/photo/202505/03.40571444.1.jpg)

![[ET시론] 바다의날 30주년과 해양 빅데이터 시대](https://img.etnews.com/news/article/2025/05/22/news-p.v1.20250522.1c6020f803074b48885e5e159213de62_Z1.jpg)

![[포토] 트리플에스 박시온, '애교 가득한 미소~'](https://img.hankyung.com/photo/202505/03.40571447.1.jpg)

English (US) ·

English (US) ·